#

TabbyAPI

Una aplicación basada en FastAPI que permite generar texto usando un LLM con el backend Exllamav2, con soporte para modelos Exl2, GPTQ y FP16.

#

Inicio Rápido

- Sigue las instrucciones de instalación en el GitHub oficial de TabbyAPI.

- Crea tu config.yml para establecer la ruta de tu modelo, modelo predeterminado, longitud de secuencia, etc. Puedes ignorar la mayoría (si no todos) de estos ajustes si lo deseas.

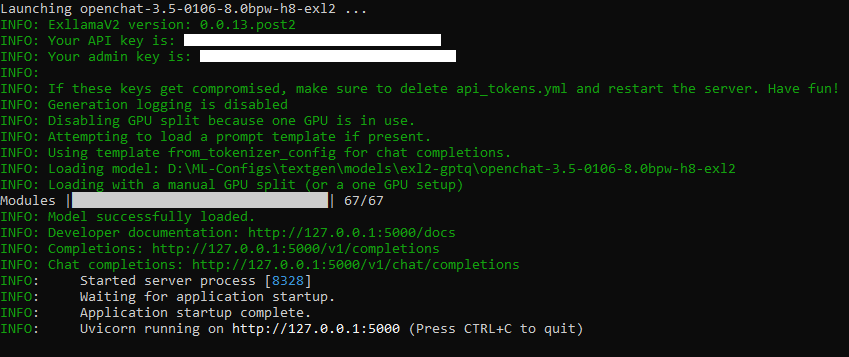

Inicia TabbyAPI. Si funcionó, deberías ver algo como esto:

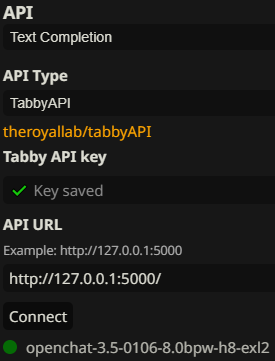

- En la API de Finalización de Texto en SillyTavern, selecciona TabbyAPI.

- Copia tu clave API de la terminal de TabbyAPI a

Tabby API keyy asegúrate de que tuAPI URLsea correcta (debería serhttp://127.0.0.1:5000de forma predeterminada).

Si lo hiciste todo correctamente, deberías ver algo como esto en SillyTavern:

¡Ahora puedes chatear usando TabbyAPI!

#

Cargador de TabbyAPI

Los desarrolladores de TabbyAPI crearon una extensión oficial para cargar/descargar modelos directamente desde SillyTavern. La instalación es simple:

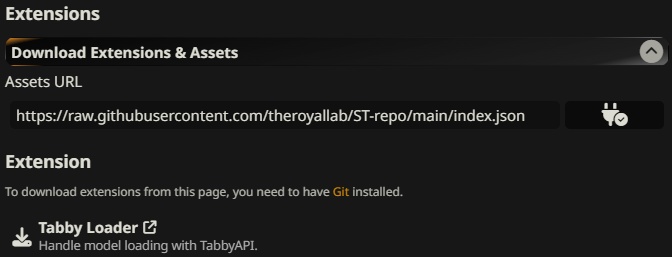

- En SillyTavern, haz clic en la pestaña Extensiones y navega a Descargar Extensiones y Recursos.

- Copia

https://raw.githubusercontent.com/theroyallab/ST-repo/main/index.jsonen Assets URL y haz clic en el botón de enchufe a la derecha. Deberías ver algo como esto. Haz clic en el botón de descarga junto a Tabby Loader.

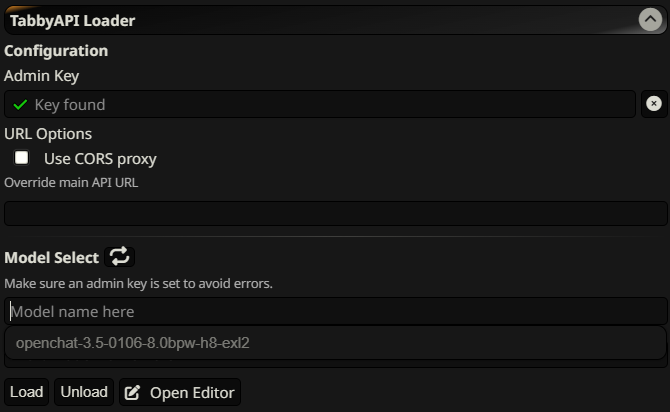

- Si la instalación fue exitosa, deberías ver un mensaje emergente verde en la parte superior de tu pantalla. En la pestaña de extensiones, navega a TabbyAPI Loader y copia tu clave de administrador de la terminal de TabbyAPI a Admin Key.

- Haz clic en el botón de actualización junto a Model Select. Cuando hagas clic en el cuadro de texto justo debajo, deberías ver todos los modelos en tu directorio de modelos.

¡Ahora puedes cargar y descargar tus modelos directamente desde SillyTavern!

#

Soporte

¿Aún necesitas ayuda? Visita el GitHub de TabbyAPI para encontrar un enlace al servidor oficial de Discord del desarrollador y lee la wiki.